Forschung

Unsere Forschung am Lehrstuhl für Psychologische Methodenlehre, Evaluation und Statistik liegt im Schnittbereich von Statistik, Psychometrie und Machine Learning.

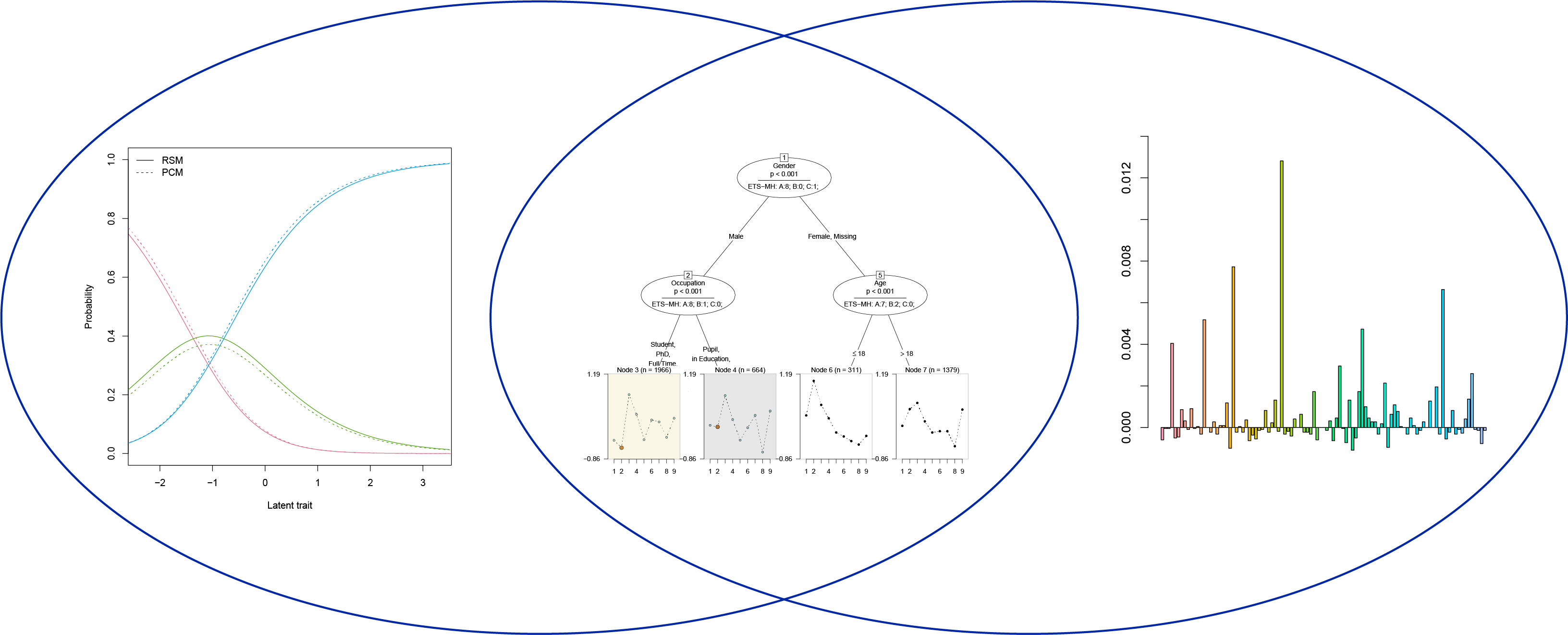

Zum Beispiel entwickeln wir Methoden zur Aufdeckung von Parameter-Unterschieden in psychometrischen Modellen, weil diese die Fairness von psychologischen Tests beeinträchtigen können. Einige dieser Methoden basieren auf klassischer, parametrischer Statistik, andere auf Ansätzen aus dem Machine Learning.

Im Bereich Machine Learning entwickeln wir Methoden zur Beurteilung der Stabilität und zur zuverlässigen Messung und Interpretation der Beiträge von Prädiktor-Variablen. Diese Themen sind auch für unsere Arbeit im Bereich Psychometric Computing relevant.

In allen drei Forschungsbereichen sind wir an der Entwicklung von Zusatz-Paketen für die kostenlose Open-Source Software R beteiligt. Diese R Pakete sind unten aufgeführt.

Psychometrie |

Psychometric Computing |

Machine Learning |

Beispiele für Forschungsprojekte mit Drittmittelförderung

Für weitere Themen siehe Publikationen

SNF-Projekt

Development of a Toolbox for Psychological Test Development

SNF-Projekt

Detecting Heterogeneity in Complex IRT Models for Measuring Latent Traits

BMBF-Projekt

Heterogenität in IRT-Modellen im BMBF-Schwerpunktfeld Kompetenzdiagnostik

DFG-Projekt

Methoden zur Berücksichtigung von Subjekt-Kovariablen in IRT-Modellen

Kollaborationen

BRIDGE Discovery Projekt

Harnessing event and longitudinal data in industry and health sector through privacy preserving technologies

SNF Sinergia Projekt

MULTICAST- A MULTIdisCiplinary Approach to prediction and treatment of Suicidality

DSI-Projekt

PREMIA - A Prediction Market with Integrated Algorithms